3Blue1Brown 深度学习视频笔记

3Blue1Brown 深度学习视频笔记

看3B1B的视频,个人感觉是以一些新的视角,或者更接近其本质、容易理解其原理的视角,来看待一些之前可能就学过的知识,只不过之前往往流于表面,没有思考这些做法的含义和目的。

# 神经网络的结构

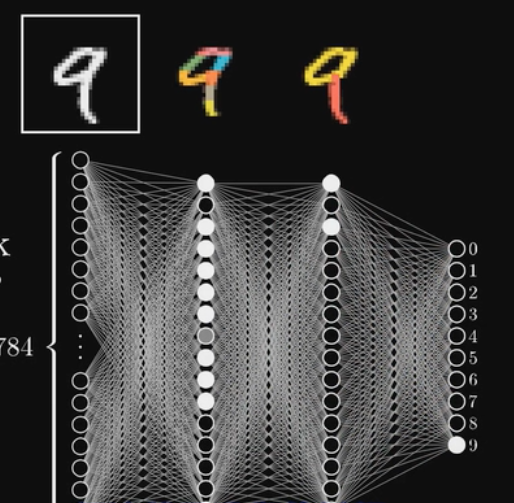

以手写数字图像识别为例,有28x28=784个像素,我们把每个像素点认为是一个神经元,里面有一个0-1的数值,越接近0越黑,越接近1越白,这个数值叫做激活值。这些神经元组成了网络的第一层。

网络的最后一层十个神经元,分别代表0-9的数字,其值越大,说明是这个数字可能性越大,选其中亮度最高的一个作为输出的识别结果。

中间的隐藏层,我们可以理解为捕获了一些不同层级的信息,例如靠前的层可以认为捕获了一些小的笔画特征(图中彩色部分代表不同的小段,每个神经元捕获其中一个小段,当数字中存在这小段时,这个神经元就被点亮),靠后的层可以捕获更高视角的信息(例如识别出一个圆圈、一条直线等)。

层之间的权重,其实代表了前一层不同神经元对后一层某个神经元的重要程度。仍然以上面识别9上部的圆圈为例,前一层中组成这些圆圈的小段,对识别圆圈比较重要,因此这些小段的神经元和圆圈神经元之间的权重就要大一些。权重告诉你后一层的神经元更关注前一层的哪些信息。

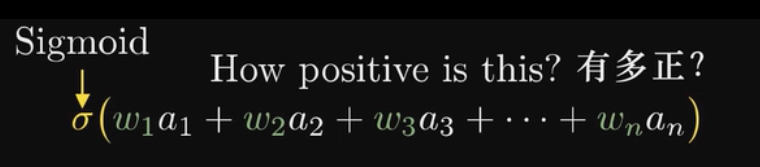

而偏置项bias的目的是设定了一个阈值,只有当加权和达到一定程度时,这个神经元才会被激活。

sigmoid的作用是将任意范围的值都能压缩到0-1范围内。实际sigmoid未必好用,尤其是当网络层次比较深时,ReLU激活函数 y = max(0, x) 可能会有更好的效果。

# 梯度下降法

# 反向传播算法

上次更新: 2022/11/11, 2:11:00